⚡️ TOON: El Nuevo Formato que Podría Desafiar a JSON en la Era de los LLM

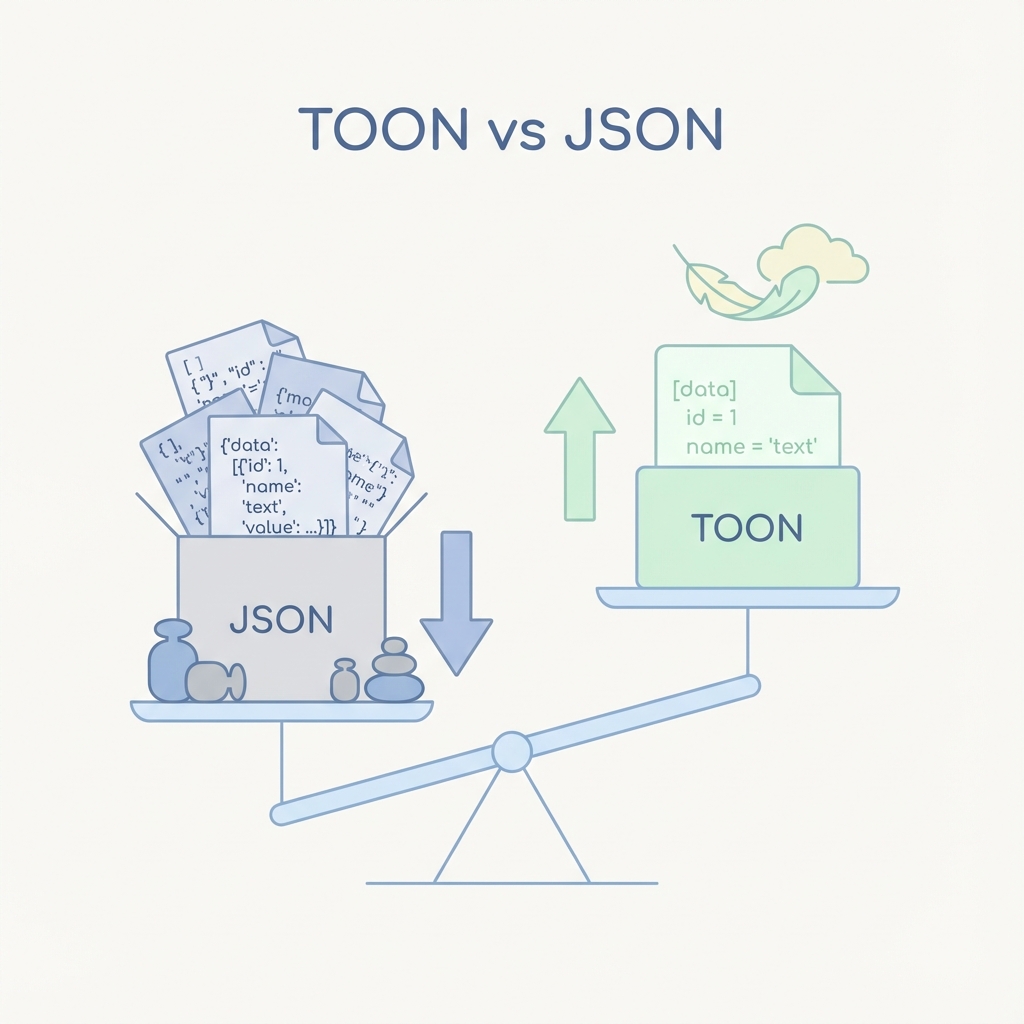

Descubre TOON (Token-Oriented Object Notation), un formato de datos compacto diseñado para optimizar datos estructurados para el consumo de LLMs, reduciendo el uso de tokens y los costes.

Cuando trabajamos con grandes modelos de lenguaje (LLMs), cada token cuenta. Los tokens afectan directamente al coste, la latencia y la cantidad de contexto útil que puedes incluir en un prompt.

JSON, aunque es excelente para APIs tradicionales y el intercambio de datos, nunca fue diseñado para un modelo de precios basado en tokens. Los corchetes, comas, comillas y nombres de campos repetidos suman rápidamente.

Aquí es donde entra TOON (Token-Oriented Object Notation) — un formato de datos construido específicamente para optimizar los datos estructurados para el consumo de LLMs.

¿Qué es TOON?

TOON (Token-Oriented Object Notation) es un formato de serialización de datos compacto y legible por humanos que representa la misma información que JSON pero con significativamente menos tokens.

Mantiene el modelo conceptual de JSON (objetos, arrays, campos) mientras elimina agresivamente la sobrecarga sintáctica que es irrelevante para el razonamiento del LLM.

En resumen: los mismos datos, menos tokens, menor coste.

JSON vs TOON (Ejemplo Rápido)

Ejemplo JSON:

{

"users": [

{ "id": 1, "name": "Alice", "role": "admin" },

{ "id": 2, "name": "Bob", "role": "user" }

]

}

Ejemplo TOON:

users[2]{id,name,role}:

1,Alice,admin

2,Bob,user

¿Qué ha cambiado?

- Los nombres de los campos se declaran una sola vez.

- No hay comillas, llaves o puntuación redundante.

- Los datos se representan en una forma tabular compacta.

Por Qué Importa Esto para los LLMs

Los LLMs tokenizan el texto de forma agresiva. Cada carácter estructural cuenta.

JSON desperdicia tokens en:

- Claves repetidas para cada objeto

- Comillas alrededor de cada cadena

- Corchetes, comas y dos puntos en todas partes

TOON elimina la mayor parte de este ruido, logrando una reducción de tokens del 30–60% en muchas cargas útiles del mundo real, especialmente cuando se trabaja con listas de registros, logs, tablas y conjuntos de datos estructurados con campos uniformes.

Los beneficios directos son claros:

- Menores costes de API

- Más espacio para instrucciones y razonamiento

- Latencia potencialmente menor

- Mejor escalabilidad para pipelines de agentes

Dónde Brilla TOON (y Dónde No)

TOON funciona especialmente bien cuando:

- Envías grandes arrays de objetos uniformes

- Alimentas datos estructurados a LLMs para análisis

- Necesitas optimizar el tamaño de la carga útil del prompt

- Comprimes la memoria o el contexto del agente

Sin embargo, tiene limitaciones:

- No reemplaza a JSON para APIs tradicionales

- Los beneficios disminuyen con datos altamente irregulares o profundamente anidados

- Los LLMs deben ser instruidos explícitamente sobre cómo leer el formato

- El ecosistema es todavía temprano en comparación con JSON

La clave: TOON es una capa de optimización para flujos de trabajo con LLM, no un formato de datos universal.

Herramientas y Ecosistema

TOON es de código abierto y ya se puede utilizar hoy.

El repositorio oficial está disponible en: github.com/johansthlm/toon

Las herramientas disponibles incluyen:

- Conversores JSON ⇄ TOON

- Herramientas CLI

- Paquetes npm

- SDKs de JavaScript y Python

- Utilidades de comparación de tokens

Esto hace que sea fácil experimentar, hacer benchmarks y adoptar TOON incrementalmente.

Un Caso de Uso Real

Imagina enviar una lista de usuarios, permisos o transacciones a un LLM para la generación de reglas de negocio, validación, análisis o soporte a la decisión.

Con JSON, una gran parte de los tokens es sobrecarga estructural. Con TOON, casi cada token lleva información real.

A escala, esto puede traducirse en miles de tokens ahorrados por petición, reducciones de costes mensuales significativas y salidas del modelo más fiables gracias al aumento del contexto efectivo.

Conclusión Estratégica

TOON no intenta reemplazar a JSON — está resolviendo un problema diferente.

A medida que los sistemas impulsados por LLM crecen:

- La eficiencia de tokens se convierte en una preocupación arquitectónica

- Las cargas útiles de los prompts se convierten en pipelines de datos

- La optimización de costes se convierte en una decisión de producto

Si estás enviando grandes cargas útiles estructuradas a LLMs, probablemente estés pagando por comas que no necesitas.

TOON ofrece una manera práctica y medible de arreglar eso — hoy mismo.

Sobre el Autor

Soy Guillermo Miranda, consultor Salesforce especializado en definir y desarrollar soluciones escalables para empresas.

¿Necesitas ayuda con Salesforce?

Ayudo a empresas a diseñar y construir soluciones Salesforce escalables.